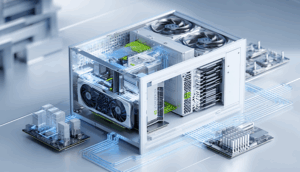

随着云计算、大数据和人工智能的快速发展,数据中心面临着前所未有的挑战。数据传输速度的提升成为了数据中心性能优化的关键。本文将深入探讨数据中心高速互连的重要性,并分析优化数据中心性能的有效策略。

数据中心高速互连的迫切需求

现代数据中心不仅仅是服务器的简单堆叠,而是复杂的网络系统,需要高速、低延迟的数据传输才能保证应用的流畅运行。传统互连技术已无法满足日益增长的带宽需求,导致数据中心内部通信瓶颈日益凸显。例如,在机器学习训练过程中,海量数据需要在不同服务器之间频繁交换,如果互连速度不足,将严重影响训练效率。

高速互连不仅关乎数据传输速度,还直接影响CPU、GPU等关键资源的利用率。当数据传输速度跟不上计算速度时,这些资源就会出现闲置,造成浪费。因此,采用先进的高速互连技术,如InfiniBand、以太网等,可以有效提升数据中心的整体性能。

此外,高速互连还能提高数据中心的可靠性和容错性。通过构建冗余的高速互连网络,可以在节点故障时快速切换,确保业务的连续性。

主流高速互连技术分析

当前数据中心领域,主流的高速互连技术主要有InfiniBand和以太网。InfiniBand以其低延迟和高带宽的特性,常被用于高性能计算和AI集群。它采用远程直接内存访问(RDMA)技术,可以绕过操作系统内核,直接在内存之间进行数据传输,从而大幅降低延迟。

以太网则具有广泛的兼容性和成熟的生态系统。通过升级到更高速率(如400GbE、800GbE),以太网也能满足部分数据中心的高速互连需求。此外,以太网也开始引入RDMA over Converged Ethernet (RoCE)等技术,以进一步降低延迟。

选择哪种技术取决于具体的应用场景和预算。InfiniBand在延迟敏感型应用中表现更佳,而以太网则在成本和兼容性方面更具优势。新型互连技术如CXL(Compute Express Link)也开始崭露头角,它能够实现CPU、GPU、内存等组件之间的高速、低延迟互连,为未来数据中心的发展提供了新的可能性。

优化数据中心高速互连的策略

除了选择合适的高速互连技术外,还可以通过以下策略来进一步优化数据中心的性能:

- 网络拓扑优化:采用扁平化的网络拓扑,如Clos网络,可以减少数据传输的跳数,降低延迟。

- 拥塞控制:实施有效的拥塞控制机制,避免网络拥塞导致的数据包丢失和延迟增加。

- QoS配置:根据不同应用的优先级,配置不同的QoS策略,确保关键应用获得足够的带宽和低延迟。

- 智能网卡:利用智能网卡(SmartNIC)将部分网络功能卸载到网卡上,减轻CPU的负担,提高网络性能。

- 软件定义网络(SDN):利用SDN技术实现网络的灵活配置和管理,优化数据传输路径。

此外,持续监控和优化高速互连网络的性能至关重要。通过实时监控网络流量、延迟和丢包率,可以及时发现问题并采取相应的措施。

数据中心高速互连相关常见问题(FAQ)

Q:InfiniBand和以太网,哪个更适合我的数据中心?

A:这取决于您的应用场景和预算。如果您的应用对延迟非常敏感,且预算充足,InfiniBand可能是更好的选择。如果您的应用对兼容性和成本更敏感,以太网可能更适合您。您需要仔细评估您的需求,并进行全面的测试,才能做出最佳选择。

Q:升级到更高速率的以太网,就能解决所有高速互连问题吗?

A:不一定。仅仅升级到更高速率的以太网并不能完全解决高速互连问题。您还需要考虑网络拓扑、拥塞控制、QoS配置等因素。此外,您的应用是否能够充分利用更高的带宽也是一个需要考虑的问题。